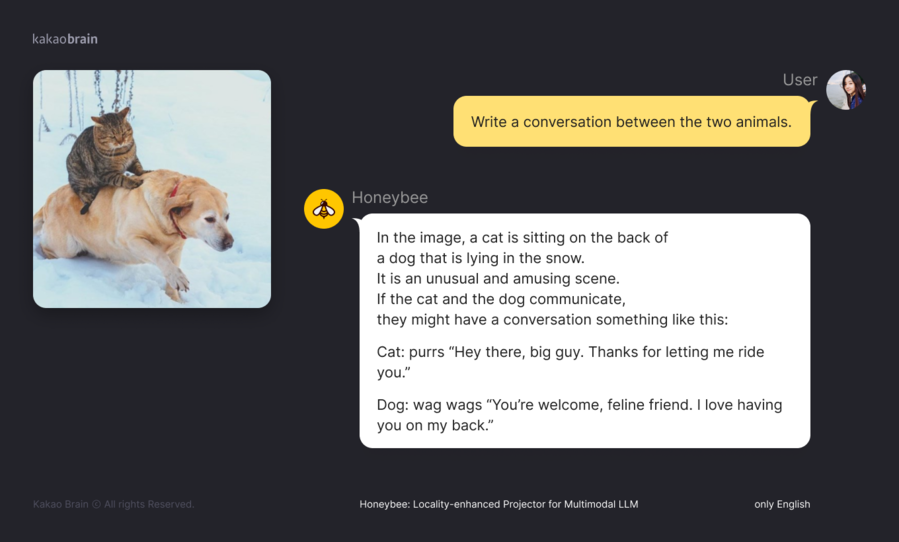

멀티모달 대규모 언어모델(MLLM) 오픈소스 ‘허니비’ 깃허브에 공개MME, MMBench, SEED-Bench 등 벤치마크 성능 입증

-

- ▲ ⓒ카카오브레인

카카오브레인이 자사가 개발한 멀티모달 대규모 언어모델(MLLM) 오픈소스 '허니비(Honeybee)'를 깃허브(Github)에 공개했다.19일 카카오브레인에 따르면 허니비는 이미지와 명령어(프롬프트)를 입력하면, 텍스트로 답변하는 모델이다. 텍스트로만 입⋅출력하는 대규모 언어모델(LLM)에서 확장된 형태다.예컨대 허니비에 '농구 경기 중인 두 명의 선수' 이미지와 함께 '왼쪽 선수는 몇 번 우승했나요?'라는 질문을 영어로 입력하면, 허니비가 입력된 이미지 내용과 질문을 종합적으로 이해하고 답변을 생성해낸다.그 결과 ‘MME’, ‘MMBench’, ‘SEED-Bench’ 등의 벤치마크(성능 실험)에서 모델이 공개된 타사 MLLM 대비 최고 성능을 달성했다. 특히 지각 능력과 인지 능력을 평가하는 MME 벤치마크에서는 2800점 만점 중 1977점을 받았다.또한 관련 논문 '허니비: 멀티모달 LLM을 위한 로컬리티 강화 프로젝터'는 지난해 논문 공개 사이트 '아카이브(arXiv)'에 게재된 바 있다. 논문에는 이 기술에 대해 "이미지 데이터를 처리해 딥러닝 모델이 더 효과적으로 학습하고 이해할 수 있도록 돕는 기술"이라고 설명했다.카카오브레인은 허니비의 MLLM 특성에 따라 이미지를 입력하고 텍스트로 질문하면 답변 생성 및 사용자와의 상호작용이 가능하다고 설명한다. 향후 효과적인 교육 및 학습 보조 도구로 사용될 것으로 전망하고 있다.김일두 카카오브레인 각자 대표는 "허니비 모델의 추론을 가능하게 하는 코드도 깃허브에 공개했으며, 각종 서비스 확장을 고려 중"이라며 "더욱 발전된 AI 모델 확보를 위해 끊임없이 연구⋅개발할 것"이라고 전했다.