대화형 언어 모델에서 대화 능력 등 정성적 성능 감소하는 문제 해결혁신적인 2가지 알고리즘 개발 … 세계적 권위의 자연어처리학회서 발표

-

- ▲ 최정욱 교수.ⓒ한양대

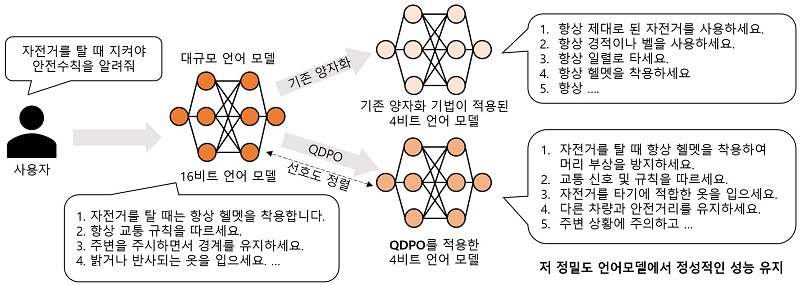

한양대학교는 융합전자공학과 최정욱 교수팀과 KT 연구팀이 대형 언어 모델(LLM)의 효율성을 획기적으로 개선하는 2가지 새 알고리즘을 개발했다고 21일 밝혔다.이번 연구는 고성능 대규모 언어 모델의 효율성을 유지하면서 정성적, 정량적 성능을 극대화하는 데 중점을 두었다.대규모 언어 모델은 심층 신경망의 가중치 수를 크게 늘려 뛰어난 성능을 발휘하지만, 일반적으로 16비트 부동소수점으로 모델 가중치와 활성화를 연산하기 때문에 막대한 저장 공간과 연산 비용이 필요하다. 이를 해결하기 위해 다양한 양자화 기법이 개발돼 저장 공간 등을 줄이는 데 기여해왔다.최 교수 연구팀은 기존 양자화 기법들이 대화형 언어 모델에서 정량적인 성능은 유지하지만, 대화 능력과 같은 정성적인 성능이 많이 감소하는 문제를 발견했다.이를 해결하기 위해 연구팀은 '양자화 인식 직접 선호 최적화(QDPO)'라는 새로운 방법을 제안했다. QDPO는 양자화된 대화형 언어 모델의 대화 능력 감소 주원인이 토큰 전환 문제에 있음을 밝혀냈다. 토큰 전환 문제는 양자화된 모델이 특정 단어를 잘못 예측해 대화의 흐름을 깨뜨리는 현상이다. 연구팀은 이를 해결하기 위해 저 정밀도 모델을 고 정밀도 모델과 정렬하는 효율적인 최적화 기법을 개발했다.QDPO는 16비트 정밀도 모델과 저 정밀도 모델을 활용해 최적화를 위한 데이터를 별도의 라벨링 없이 자동 생성하며, 이를 통해 대화 능력을 유지하거나 향상하는 것을 목표로 한다. 실험 결과 QDPO를 적용한 4비트 저 정밀도 모델은 기존 4비트 양자화 기법과 비슷한 정량적 성능을 유지하면서도 GPT-4와 같은 최신 모델을 활용한 정성적 벤치마크에서 우수한 성능을 보였다. -

- ▲ 양자화 인식 직접 선호 최적화(QDPO)의 효과.ⓒ한양대

또한 연구팀은 두 번째 문제인 저비트 양자화 환경에서의 성능 저하 문제를 해결하기 위해 'RA-LoRA(Rank-Adaptive Low-Rank Adaptation)'라는 방법을 개발했다. 기존의 LoRA 기법은 모델의 메모리 사용량을 줄이기 위해 일부 파라미터만 조정하는 방식이었으나, 이는 양자화 오류를 충분히 보정하지 못했다. 이를 보완하기 위해 RA-LoRA는 랭크 서브스페이스 분석을 통해 어댑터의 랭크를 동적으로 조정해 최적의 성능을 유지할 수 있게 설계됐다.랭크 서브스페이스 분석은 각 레이어의 특성과 입력 데이터에 따라 적절한 랭크를 선택하는 과정을 포함한다. 이를 통해 RA-LoRA는 적은 파라미터로도 높은 정확도를 유지할 수 있다. 이는 특히 2비트 양자화 환경에서 두드러진다. 실험 결과 RA-LoRA는 DeBERTa-V3 및 LLaMA-2 모델을 사용한 2비트 효율적인 미세 조정에서 기존의 방법보다 뛰어난 성능을 보였다. RA-LoRA는 다양한 NLP 작업에서 기존의 양자화가 적용된 LoRA 기법보다 더 우수한 성능을 기록했다.첫 번째 논문(Improving Conversational Abilities of Quantized Large Language Models via Direct Preference Alignment)은 한양대 융합전자공학과 이장환·박성민 박사과정생이 공동 제1저자로 참여했다.두 번째 논문(RA-LoRA: Rank-Adaptive Parameter-Efficient Fine-Tuning for Accurate 2-bit Quantized Large Language Models)은 한양대 융합전자공학과 김민수 박사과정생이 제1저자, 서울대 성원용 교수가 참여 연구자로 참여했다. 최 교수는 두 논문의 교신저자로 참여했다.이들 논문은 지난 11~16일 진행된 세계 권위의 자연어처리 학회 'ACL 2024: The 62nd Annual Meeting of the Association for Computational Linguistics'에서 발표됐다.