MIT CSAIL, AI 편집 기능으로부터 원본 이미지 보호하는 '포토가드' 개발눈에 보이지 않는 '노이즈' 삽입해 AI의 이미지 생성 기능 방해"AI와 AI로 인한 잠재적 위협 대응하는 방어 기술, 빠른 속도로 함께 진화"

-

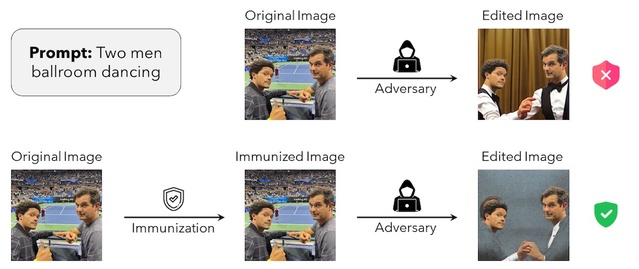

- ▲ MIT가 개발한 '포토가드' 기술. ⓒMIT / GitHub

미국 매사추세츠 공대(MIT)가 인공지능(AI)이 조작해내는 가짜 이미지로부터 원본을 지킬 수 있는 도구인 '포토가드(Photoguard)'를 개발했다.27일 업계에 따르면 최근 AI 기술이 진화를 거듭하면서 인물 사진과 예술 작품 등의 이미지를 무단으로 사용하거나 조작하는 사례가 늘고 있다. AI가 만들어 낸 이미지들이 점점 정교해지면서 '가짜 뉴스'와 같은 허위 정보가 퍼져나가거나, 악의적으로 조작된 이미지로 인해 사람들이 피해를 입는 경우도 발생하면서 사회·경제적으로 큰 파장이 일고 있다.이 같은 문제에 대응하기 위해 MIT의 컴퓨터 사이언스·인공지능 연구소(CSAIL)는 AI 편집 기능으로부터 원본 이미지를 보호하는 혁신적인 해결책을 고안해낸 것이다. -

- ▲ MIT가 개발한 '포토가드' 기술. ⓒMIT / GitHub

온라인 오픈소스 플랫폼 '깃허브(Github)'를 통해 공개된 '포토가드'는 데이터 포이즈닝(data poisoning, 악의적인 데이터, 혹은 잘못된 데이터를 투입해 AI가 유해한 결정을 내리도록 하는 것) 기술을 적용해 감지되거나 눈에 보이지 않는 노이즈(noise)를 이미지에 삽입하는 방식이다. 사람의 눈에는 감지되지 않는 이 노이즈는 가짜 이미지를 생성해내는 AI의 기능을 방해하는 역할을 한다.'포토가드'는 AI 알고리즘이 이미지를 정확하게 인식하고 복제하는 것을 방지함으로써 악의적인 편집을 방지하는 전략을 취한다. - 유튜브(YouTube)를 통해 공개된 인터랙티브 데모 영상에 따르면, '포토가드'를 사진에 적용할 경우 AI 이미지 생성기가 해당 이미지를 새로운 사진으로 생성하지 못하도록 막는 일종의 '장벽' 역할을 하게 된다. '포토가드'가 적용된 사진은 시각적으로는 차이점을 분간할 수 없는 상태로 유지되면서도 AI의 정교한 조작 기능으로부터 면역 시스템을 갖추게 된다.데모 영상에서는 코미디언 트레버 노아(Trevor Noah)와 마이클 코스타(Michael Kosta), 일론 머스크(Elon Musk) 테슬라(Tesla) 최고경영자(CEO) 등 유명인의 사진에 '포토가드'를 적용한 뒤, AI로 새로운 이미지를 만드는 과정이 담겨있다.'포토가드'를 적용하지 않은 원본 이미지는 AI에 의해 너무도 간단하고 정교하게 다른 이미지로 탈바꿈했다. 똑같은 원본 이미지에 '포토가드'를 적용하자, AI는 해당 이미지를 제대로 인식하지 못한 채 엉성하고 어색한 이미지를 만들어냈다. '포토가드'가 AI의 이미지 생성을 성공적으로 방지한 것이다. 자신이 온라인에 올린 이미지가 AI에 의해 변경되거나 조작되는 것을 원치 않는 사람은 '포토가드'를 적용하기만 하면 된다.그러나 '포토가드'의 독창적인 아이디어에도 불구하고, 완전한 예방책은 아니라는 지적도 나오고 있다. 다른 방어 매커니즘(defense mechanism)과 마찬가지로 '포토가드'도 극명한 한계점을 갖고 있다. 누군가 또 다른 디지털 노이즈를 추가하거나, 이미지를 좌우로 반전시키거나, 일부만 편집해서 사용하는 등 '포토가드'가 적용된 이미지를 역설계 할 가능성도 있기 때문이다.'포토가드'가 AI 조작으로부터 온라인 예술 작품과 원본 이미지를 보호하는 데 있어 중대한 진전을 이룬 것은 분명하지만, 업계에서는 기술의 발전과 보안 문제 사이에서 끊임없이 계속되는 '고양이와 쥐의 싸움(cat-and-mouse game)'을 보여주는 단적인 예로 거론되고 있다. AI는 물론, 해당 기술이 야기할 수 있는 잠재적인 위협에 맞서기 위한 방어 기술도 빠른 속도로 함께 진화해가고 있다.