AA 인텔리전스 지수 32점·세계 7위 제시 … 허깅페이스 트렌드 2위 올라LG "28일까지 K-엑사원 API 무료" … 국내 대학원생 50명이상 인턴십 지원

-

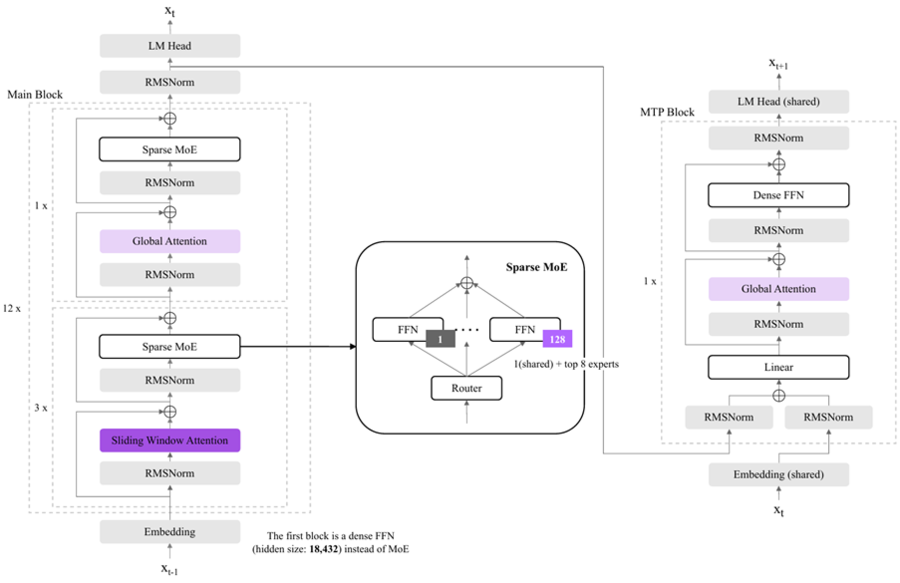

- ▲ K-엑사원 모델 구조ⓒLG AI연구원

LG AI(인공지능)연구원이 오픈 웨이트 모델 K-엑사원(EXAONE)을 공개했다. LG는 K-엑사원이 독자 AI 파운데이션 모델 프로젝트 1차 평가에서 13개 벤치마크 테스트 중 10개 1위를 차지했고, 전체 평균 점수는 72점으로 5개 정예팀 모델 가운데 가장 높았다고 밝혔다.글로벌 성능 평가지표로는 아티피셜 어낼리시스(Artificial Analysis) 인텔리전스 지수를 제시했다. LG는 K-엑사원이 인텔리전스 지수에서 32점을 기록해 오픈 웨이트 모델 기준 세계 7위, 국내 1위에 올랐다고 11일 설명했다.이진식 LG AI연구원 엑사원랩장은 “보유 데이터의 절반 정도만 사용해 1차수 K-엑사원을 만들었다”며 “앞으로 본격적으로 성능을 끌어올린 K-엑사원을 선보이겠다”고 말했다. LG는 K-엑사원을 허깅 페이스(Hugging Face)에 오픈 웨이트로 공개한 직후 글로벌 모델 트렌드 순위 2위에 올랐다고도 밝혔다.LG는 K-엑사원이 미국 비영리 AI 연구 기관 에포크(Epoch) AI의 ‘주목할 만한 AI 모델(Notable AI Models)’에 포함됐다고 밝혔다. 이와 함께 LG AI연구원이 2024년 엑사원 3.5를 시작으로 엑사원 딥(Deep), 엑사원 패스(Path) 2.0, 엑사원 4.0까지 국내 기업 중 최다인 5개 모델을 해당 리스트에 올렸다고 설명했다.핵심 메시지는 ‘고효율 설계’다. LG는 데이터 양 확대가 아니라 성능은 높이고 학습·운용 비용은 낮추는 방식으로 모델 구조 자체를 혁신했다고 밝혔다.구체적으로 엑사원 4.0에서 검증된 하이브리드 어텐션(Hybrid Attention)을 고도화해 적용했고, 슬라이딩 윈도우 어텐션과 글로벌 어텐션을 조합하는 방식으로 메모리 요구량과 연산량을 엑사원 4.0 대비 70% 절감했다고 설명했다.언어 처리 효율도 손봤다. LG는 토크나이저(Tokenizer) 학습 어휘를 15만개로 확장하고, 자주 쓰는 단어 조합을 하나로 묶는 방식 등을 적용해 기존 모델 대비 1.3배 더 긴 문서를 기억하고 처리할 수 있게 했다고 밝혔다. 멀티 토큰 예측(MTP) 영역을 설계해 추론 속도는 기존 모델 대비 150% 높였다고도 했다.모델 규모는 파라미터 2360억개로 제시됐다. 다만 전문가 혼합(MoE) 방식으로 실제 활성 매개변수는 10% 규모인 230억개라고 설명했다. 학습 범위를 확장해 국내 AI 모델 중 가장 긴 26만토큰 문맥을 한 번에 이해·처리할 수 있으며, 이는 A4 문서 기준 400장이상 분량에 해당한다고 밝혔다.LG AI연구원은 “효율은 높이고 비용은 낮추는 모델 설계를 통해 A100급 GPU 환경에서도 구동할 수 있다”고도 설명했다.학습 설계와 안전성·신뢰성 프레임도 전면에 배치했다. LG는 사전 학습 단계에서 사고 궤적(Thinking Trajectory) 데이터를 활용했고, 사후 학습 과정에서는 강화학습 알고리즘 아가포(AGAPO)와 선호학습 알고리즘 그루퍼(GrouPER) 등 독자 기술을 적용했다고 밝혔다.또 저작권 문제가 있는 데이터를 사전에 식별·제외하는 등 모든 학습 데이터에 대해 데이터 컴플라이언스(Data Compliance) 평가를 진행하고, 자체 AI윤리위원회를 통해 위험 분류 체계를 수립해 안전성 테스트를 진행했다고 설명했다.생태계 확장 계획도 함께 내놨다. LG는 허깅 페이스에 K-엑사원과 함께 모델 구조 설계, 학습 방법, 성능 평가 결과 등을 담은 기술 보고서(Technical Report)를 공개했다고 밝혔다.또 프로젝트 인턴을 지속 선발해 50명이상의 국내 대학원생이 AI 파운데이션 모델 개발 경험을 쌓을 수 있도록 지원할 계획이다. 서울대학교, KAIST, 미국 미시간대학교 등과 공동 연구도 진행하고 있다.LG AI연구원은 1월 28일까지 K-엑사원 API를 무료로 제공한다고 밝혔다.

![[단독] 삼성전자 외국인 보유율 50% 깨졌다 … 지난해 4월 ‘관세 공포’ 이래 최초](https://image.newdaily.co.kr/site/data/thumb/2026/03/06/2026030600254_0_thumb.jpg)