AI칩 MI350 시리즈에 288GB 탑재최신기술로 HBM3E 성능·용량 동시 개선차세대 MI400에 HBM4 공급 가능성 커져

-

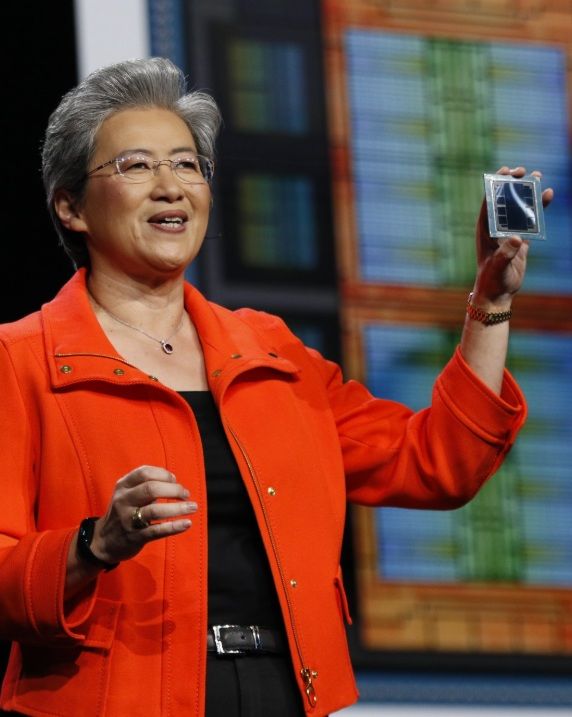

- ▲ 리사 수 AMD 최고경영자(CEO)가 12일(현지시간) 미국 캘리포니아주 새너제이에서 열린 ‘AI 어드밴싱 2025’ 행사에서 신형 AI 가속기 MI350 시리즈를 소개하고 있다.ⓒAMD SNS

삼성전자가 AMD의 최신 인공지능(AI) 가속기 'MI350' 시리즈에 고대역폭메모리(HBM)3E 12단 제품을 공급한다. 그간 엔비디아 납품에서 고전하던 삼성전자로서는 의미 있는 전환점이자 향후 HBM4 시장에서의 입지 회복 기대감을 높이는 계기가 될 것으로 기대된다.AMD는 12일(현지 시간) 미 산호세 컨벤션센터에서 열린 'AI 어드밴싱 2025'에서 신형 AI 가속기 MI350X·MI355X에 삼성전자·마이크론 HBM3E 12단을 탑재한다고 밝혔다.행사에서 AMD는 MI350X와 MI355X 모델에 삼성전자 및 마이크론의 HBM3E 12단을 채택했다는 사실을 공개했다. 삼성전자가 AMD에 HBM을 납품 중이라는 정황은 업계에 알려져 있었지만 AMD가 이를 직접 인정한 것은 이번이 처음이다.MI350 시리즈는 GPU 8개를 묶은 플랫폼 기준으로 총 2.3TB의 HBM3E를 탑재한다. 두 모델 모두 288GB 메모리를 제공하며 전작 MI300X(192GB), MI325X(256GB) 대비 용량이 확대됐다. 냉각 방식에 따라 제품 간 최고 속도 차이가 있을 뿐 기본적인 칩셋은 동일하다.이번에 공급된 HBM3E는 삼성전자가 지난해 개발 완료한 36GB 용량의 12단 제품으로 24Gb D램 칩을 TSV(Through-Silicon Via) 기술로 적층해 구성됐다. 전작인 8단 제품 대비 성능과 용량이 50% 이상 향상됐으며 초당 최대 1280GB의 대역폭과 1024개의 입출력 통로를 통해 초당 최대 10Gb 속도를 구현한다.특히 삼성전자는 이번 12단 제품에 '어드밴스드 TC NCF' 기술을 도입, 패키지 높이는 유지하면서 칩 간 간격을 7마이크로미터까지 줄였다. 여기에 서로 다른 크기의 범프를 위치별로 배치해 신호 간섭과 발열 문제도 개선했다.AMD가 내년 출시 예정인 MI400 시리즈에는 GPU당 432GB의 HBM4가 탑재될 예정이다. 리사 수 AMD CEO는 "엔비디아의 베라 루빈 서버랙과 연산 능력은 동등하나, HBM 용량과 대역폭은 1.5배"라고 강조했다. 총 72개의 GPU로 구성되는 서버랙 '헬리오스'는 31TB에 달하는 HBM 용량을 바탕으로 현 세대 MI355X 서버랙 대비 10배의 AI 연산력을 자랑한다.업계에서는 HBM4가 향후 시장 점유율 판도를 좌우할 중요한 분기점으로 보고 있다. HBM4는 최근 JEDEC의 표준화가 완료되며 양산 준비에 돌입했다. 삼성전자와 SK하이닉스는 연말 양산을 목표로 하며 이 중 삼성전자는 HBM4에서 6세대 10나노급(1c) 공정을 도입해 우위를 확보한다는 전략이다.업계 관계자는 "향후 HBM4 시장을 누가 선점할지에 따라 HBM 경쟁 구도가 뒤집어 질 수 있다"며 "SK하이닉스 중심의 HBM 공급망이 재편될지 주목된다"고 말했다.