AI 이미지 생성 원리를 언어모델에 적용 … 기존 언어모델보다 3배 이상 빠른 생성 속도긴 글 생성에서 발생할 수 있는 문법 오류 등 불안정성 줄이는 방법론도 함께 제시세계 최고 권위 AI 학회서 상위 3% 논문에 주는 '주목할 만한'등급으로 뽑혀

-

- ▲ 연세대 연구팀. 왼쪽부터 인공지능학과 서영빈 연구원, 여진영 교수, 김재형 교수, 이동하 교수.ⓒ연세대

연세대학교는 인공지능융합대학 서영빈 연구원이 기존 거대언어모델(LLM)보다 빠르고 안정적인 '디퓨전 언어모델(Diffusion LLM)' 연구로 세계 최고 권위의 머신러닝 학회인 뉴립스(NeurIPS)에서 주목할 만한 우수 논문(Spotlight) 등급으로 채택됐다고 25일 밝혔다.뉴립스는 챗GPT 등 주요 인공지능(AI) 연구 성과가 발표된 국제 학회다. 스포트라이트 등급은 전체 제출작 중 상위 3%에만 주어진다. 이번 성과는 국내 연구기관이 주도한 디퓨전 언어모델 연구가 국제적으로 검증받은 최초의 사례라는 점에서 의미가 있다.이번 논문 '합성곱 디코딩과 거부 기반 미세조정을 통한 빠르고 유창한 확산 언어모델(Fast and Fluent Diffusion Language Models via Convolutional Decoding and Rejective Fine-tuning)'은 최근 '나노 바나나' 등 이미지·영상 생성 분야에서 주목받은 디퓨전 패러다임을 언어 생성에 적용한 것이다. AI 이미지를 생성할 때 노이즈를 점차적으로 제거하면서 데이터를 생성하는 방식으로, 최근 연구에선 텍스트 생성에도 이를 활용하려는 시도가 있다. 오픈AI의 챗GPT 같은 자가회귀(autoregressive) 언어모델이 1000단어를 생성하려면 1000단계를 거쳐야 하지만, 디퓨전 언어모델은 100여 단계 만에 결과를 낼 수 있다. 연구팀은 "사람 머릿속에서 생각이 한 번에 '반짝' 떠오르는 것과 유사한 방식으로 빠르고 유창한 생성이 가능하다"고 설명했다. -

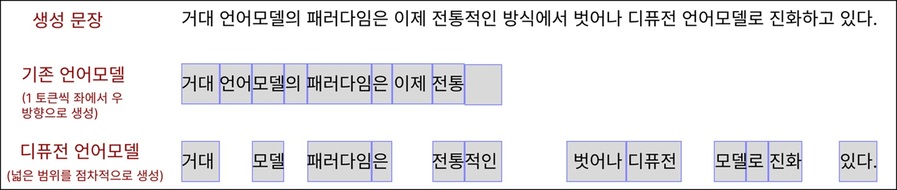

- ▲ 기존 언어모델과 디퓨전 언어모델이 문장을 생성하는 방식. 기존 언어모델이 좌에서 우로 한 토큰(형태소나 단어)씩 생성하는 데 반해, 디퓨전 언어모델은 넓은 범위에서 한 번에 여러 토큰을 점차적으로 생성한다.ⓒ연세대

연구팀은 디퓨전 언어모델의 한계인 불안정성을 줄이는 방법론도 제시했다. 디퓨전 언어모델은 한 번에 여러 단어를 생성할 수 있는 장점이 있지만, 긴 글에서는 문법 오류나 문맥의 불연속성이 발생하기 쉽다. 연구팀은 이를 해결하고자 컨볼루션 디코딩(Convolutional Decoding)과 R2FT(Rejecting Rule-based Fine-Tuning)라는 2가지 기법을 도입했다. 그 결과 기존 언어모델보다 3배 이상 빠른 속도를 내면서도 문법적 안정성과 질의응답 성능을 유지했다.디퓨전 언어모델은 스탠퍼드, 매사추세츠공과대학(MIT) 등 세계 유수 연구실에서도 활발히 연구되는 분야다. 이번 연구는 국내 최초로 세계 최고 AI 학회의 검증을 받아 의의가 크다.서영빈 연구원은 "디퓨전 언어모델의 장점인 빠른 속도와 양방향 주의는 강화학습에서도 중요한 특성"이라며 "이런 장점 덕분에 기존 자가회귀 패러다임을 대체할 가능성이 있다고 보고 연구를 시작했다"고 말했다.이번 연구는 여진영·김재형·이동하 인공지능학과 교수와의 협력으로 진행됐다. 여 교수는 "이번 성과는 기존 언어모델을 대체할 핵심 기술로서 디퓨전 언어모델의 잠재력을 한 단계 끌어올렸다"며 "최근 챗GPT와 같은 챗봇 서비스에서도 오랜 시간 생각을 거쳐 답변을 시작하는 방식이 보편화되고 있기 때문에 생성 속도를 비약적으로 끌어올릴 수 있는 디퓨전 언어모델은 산업적 잠재성이 높다"고 설명했다.연구팀은 코드와 구현을 공개해 재현성과 실용성을 높였다. 논문에는 깃허브 저장소가 명시돼 있다. 방법론도 상술돼 있다.한편 뉴립스는 오는 12월 2~7일 미국 샌디에이고 컨벤션센터에서 열린다. -

- ▲ 연세대학교 전경. 우측 상단은 윤동섭 총장.ⓒ연세대