적대적 설명 방법론 적용해 우수한 임상적 활용도 갖춰

-

- ▲ ⓒ서울대병원

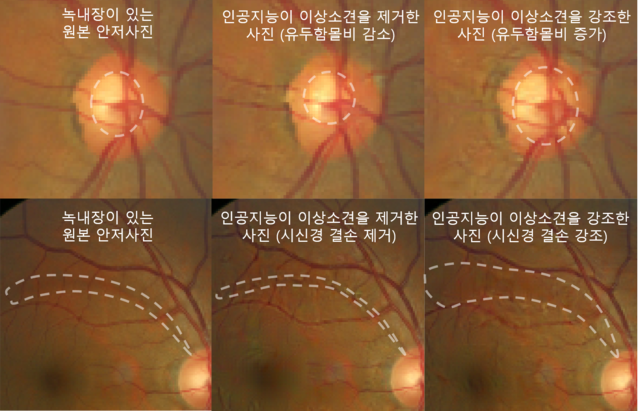

병변 위치뿐 아니라 진단을 내리게 된 의학적 소견까지 보여주는 새로운 녹내장 진단 설명가능 AI(eXplainable AI, XAI)가 개발됐다.서울대병원은 안과 박기호·가정의학과 박상민 연구팀이 안과 의사가 녹내장을 진단할 때 임상적으로 해석할 수 있는 새로운 설명가능 AI를 개발했다고 30일 밝혔다.녹내장은 실명을 일으키는 대표적인 안과 질환으로 특별한 증상 없이도 진행될 수 있고 치료시기를 놓치면 회복이 불가할 뿐만 아니라 치료비도 기하급수적으로 올라가는 질환이다. 무엇보다 정확한 진단으로 조기 치료가 중요하다.연구팀은 서울대병원 건강증진센터 환자 코호트의 안저사진 6천장을 3회 중복해 정밀 판독하고 녹내장 진단을 위한 인공지능을 학습시켰다.이후 녹내장 진단을 내린 과정을 설명하기 위해 완성된 인공지능에 적대적 설명(Adversarial Explanation) 방법론을 적용했다.적대적 설명 방법론은 인공지능이 안저사진을 녹내장이라고 판단하도록 변형시킨 적대적 예제를 생성한다.이때 적대적 예제에 녹내장 소견이 추가되거나 강조되는 것을 의사가 확인함으로써 인공지능의 녹내장 이해도를 확인할 수 있다. 반대로 인공지능이 정상으로 판단하는 적대적 예제를 생성하여 실제 녹내장 소견이 제거되는지 확인할 수도 있다.적대적 설명 방법론을 적용해 설명 가능한 의료영상판독용 인공지능을 개발한 것은 연구팀이 세계 최초다.연구팀은 적대적 예제를 통해 실제로 녹내장 소견이 변화된 것을 확인했다. 더불어 안과 의사 대상 설문조사 결과, 적대적 설명을 이용하는 것이 기존의 방식보다 인공지능을 더 잘 이해하는 데 도움이 된다고 알려졌다.장주영 연구원(1저자) “단순히 진단의 정확도만 높이는 AI 기술뿐 아니라, 안과 의사들이 이해할 수 있도록 설명하는 인공지능을 개발하는 것이 매우 중요하다”고 말했다.박기호 교수(안과)는 “이번에 개발된 AI 설명 방법론은 병변의 위치만을 보여주는 기존의 히트맵(Heatmap) 방식보다 더 높은 설명력을 가지며, 녹내장 진단을 내리게 된 의학적 소견을 함께 보여준다”고 강조했다.박상민 교수(가정의학과)는 “기존 AI가 가지던 블랙박스 문제를 해결한 새로운 설명가능 AI 기술은 신뢰성을 높여 향후 인공지능 의료기기의 인증과 사용성 확대에 중요한 원천기술”이라며 “이를 기반으로 해 인간과 AI의 상호 의사소통을 촉진하는 인공지능 의료기기를 개발할 예정”이라고 향후 계획을 밝혔다.서울대병원과 인더스마트의 협력 연구로 진행된 이 논문은 안과학 분야에서 국제적으로 가장 권위 있는 미국안과학회(AAO)의 공식 학술지 '옵살몰로지(Ophthalmology)’ 최근호에 게재됐다.